Benutzer-Werkzeuge

Dies ist eine alte Version des Dokuments!

Inhaltsverzeichnis

todo Es gibt Seiten zu VMWare und vSphere

Siehe vSphere. VMWare unterstützt NUMA. Siehe VMWare NUMA.

Man kann vSphere mit PowerCLI automatisieren.

Photon OS ist ein minimalistisches Container-Host-Linux, das für den Betrieb auf VMware-Plattformen optimiert ist, aber auch in anderen Umgebungen laufen kann.

Dateiformate

Templates werden als OVF (Open virtualization format) Dateien gespeichert.

- VMDK Dateien bilden virtuelle Festplatten ab.

- VMX Dateien sind Konfigurationsdaten für eine virtuelle Maschine. Dazu zählen unter anderem Angaben zur virtuellen Hardware (Zahl der CPUs, verfügbares RAM), zur Art der Netzwerkanbindung (NAT, bridged, etc) oder zu den VMware Tools.

- VMSD Dateien sind Snapshots einer VM.

Siehe auch die Liste der VMWare Dateiformate

Produkte

- VMWare PowerCLI DeepDive

- VMWare ESXi (Bare metal Hypervisor Typ 1)

- VMWare vCenter Server (zentrales Management der Infrastruktur) benutzt zum speichern der Infrastruktur eine Datenbank. MSSQL und Oracle werden unterstützt

- VMWare Horizon VDI Virtual desktop infrastructure (terminal)

- VMWare vSphere DRS (distributed resource scheduler) verteilt VM-Workloads auf vSphere-Hosts innerhalb eines Clusters und überwacht die verfügbaren Ressourcen. Je nach Automatisierungsstufe (Disabled, Manuel, Partially Automatic, Fully Automatic) migriert DRS (VMware vSphere vMotion) virtuelle Maschinen auf andere Hosts innerhalb des Clusters, um die Last gleichmäßig zu verteilen und damit die Performance zu maximieren. Siehe NUMA. Siehe vSphere6 - DRS

- VMWare vRealize Orchestrator https://www.vmware.com/at/products/vrealize-orchestrator.html

- VMWare vSphere Client and Web Client (Zugriff auf vCenter server)

- VMWare vSphere Replication Site recovery manager (SRM)

- VMWare Tanzu Simplifies multi-cloud operations

- VMWare HCX (Hybrid cloud extension)

- VMWare NSX (NSX-V (Nur VMWare Hypervisor), NSX-T (Multi Hypervisor)) Network and Security management

- VMWare vSphere Update Manager (Updates für ESXi Hosts)

- VMWare vMotion Live-Migration von Workloads von einem Server auf einen anderen ohne Ausfallzeit. Siehe EVC - Enhanced vMotion Compability

- VMWare Workstation Player

- VMWare vSphere Integrated Containers (kein Support mehr, von Tanzu abgelöst) Also known as VMware Admiral, vSphere Integrated Containers Management Portal provides a UI for DevOps teams to provision and manage containers, including the ability to obtain statistics and information about container instances.

- und noch viele weitere Produkte

Resource Pools

Computing Power wie CPU, Cache und RAM wird in logische Resource Pools eingeteilt. Diese können hierarchisch miteinander verknüpft werden und stellen eine Isolierung vergleichbar mit Namespaces dar. Quotas sind konfigurierbar.

Dienste

- vpxd - Der Hauptdienst auf dem vSphere Server

- vpxa - Der Agent auf jedem esx Host der im vCenter Server gemanagt wird

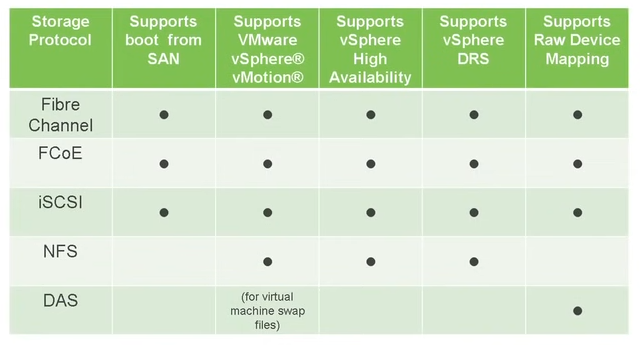

Storage

Ein wesentlicher Aspekt in vSphere ist die Speicherinfrastruktur, die die Speicherung von VMs, Dateien und Konfigurationen verwaltet.

Für den Shared Storage kommt blockbasiertes Fibre Channel und/oder iSCSI zum Einsatz. Should i use iSCSI or Fibre Channel

Storage-Geräte werden hostübergreifend zu verschiedenen Arten von Clustern (Datastores) zusammengefasst und sind als Speicherpool von den VMs nutzbar. Als Caching-Speicher kommen Flash-basierte Speicher wie SSDs, NVMe-Devices (zum Anschluss von SSDs über PCIe) oder NVDIMM (nicht flüchtiger Speicher im DIMM Format) zum Einsatz.

Siehe auch VVol.

Datastore

Ein Datastore ist ein logischer Speicherbereich in vSphere, der den Speicherplatz für VMs und andere Dateien bereitstellt. Er kann aus verschiedenen Speicherressourcen wie lokalen Festplatten, RAID-Arrays, SANs oder NAS bestehen. Ein Datastore stellt den ESXi-Hosts in der vSphere-Umgebung den Speicherplatz zur Verfügung.

Datastores ermöglichen eine zentralisierte Verwaltung und Organisation des Speicherplatzes in vSphere. Sie werden verwendet, um die VMDK-Dateien (virtuelle Festplatten) der VMs zu speichern sowie andere Dateien wie Konfigurationsdateien, Snapshots und ISO-Images. Thin Provisioning, Deduplizierung und Komprimierung sind einige der unterstützten Speicherfunktionen.

Es gibt verschiedene Arten von Datastores in vSphere: VMFS-Datastore (Virtual Machine File System), NFS-Datastore (Network File System) und vSAN-Datastore (Virtual SAN). Jeder Typ hat spezifische Merkmale und wird entsprechend den Anforderungen der Umgebung eingesetzt.

LUN

Eine LUN ist eine eindeutige Kennung, die einem logischen Speichergerät zugeordnet ist. Sie wird häufig in Storage Area Networks (SANs) verwendet und repräsentiert ein logisches Volume auf einem Speichersystem. Eine LUN wird normalerweise einem oder mehreren Hosts präsentiert und ermöglicht den Zugriff auf den darunterliegenden Speicherbereich.

Die LUN ist das logische Volume, das von einem Speicherarray oder einem SAN bereitgestellt wird. Sie kann aus physischen Festplatten, RAID-Arrays oder anderen Speicherressourcen bestehen. Einmal einem oder mehreren Hosts zugewiesen, können diese auf die LUN zugreifen und darauf Datastores erstellen.

ESX-Hosts erstellen Datastores auf der LUN, um Speicherplatz für die VMs bereitzustellen. Ein Datastore repräsentiert den Speicherbereich, auf dem VMs und andere Dateien in vSphere gespeichert werden. Die Verwendung von LUNs und Datastores ermöglicht eine effiziente Speicherbereitstellung und -verwaltung.

Es gibt auch vSAN.

Siehe VMWare VMFS Storage erstellen, vSphere Storage Profiles.

Grafikkarten

Insgesamt gibt es vier gängige Methoden, um Grafikkarten in VMware zu nutzen:

- Virtual Shared Graphics Acceleration (vSGA): Diese Methode ermöglicht es mehreren virtuellen Maschinen, gemeinsam eine Grafikkarte zu nutzen.

- Virtual GPU (vGPU): Hierbei wird eine virtuelle Grafikkarte erstellt, die auf einer physischen Grafikkarte basiert und von einer oder mehreren virtuellen Maschinen verwendet werden kann.

- Direct Passthrough (Direct Assignment): Bei dieser Methode wird einer virtuellen Maschine eine dedizierte physische Grafikkarte direkt zugewiesen.

- GPU-Passthrough: Hierbei wird eine oder mehrere Grafikkarten einem speziellen Gastbetriebssystem direkt zugewiesen, um die volle Leistung und Funktionen der Grafikkarten zu nutzen.

| Name | Beschreibung |

|---|---|

| Virtual Shared Graphics Acceleration (vSGA) | Stellen Sie sicher, dass Ihre Hardware vSGA unterstützt. Dazu gehört eine kompatible Grafikkarte, die in Ihrem Server installiert ist. Installieren Sie den VMware ESXi-Hypervisor auf Ihrem Server und konfigurieren Sie ihn entsprechend. Erstellen Sie eine virtuelle Maschine (VM) in VMware vSphere. Weisen Sie der VM eine virtuelle Grafikkarte zu, indem Sie den vSGA-Mechanismus auswählen. Dies ermöglicht es der VM, auf die Grafikkartenressourcen des Servers zuzugreifen. Installieren Sie die Treiber für die virtuelle Grafikkarte in der VM. |

| Virtual GPU (vGPU) | Stellen Sie sicher, dass Ihre Hardware und VMware-Lizenzierung vGPU unterstützen. Dies erfordert spezielle Hardware wie NVIDIA GRID-Grafikkarten oder AMD MxGPU-Technologie. Installieren Sie den VMware ESXi-Hypervisor auf Ihrem Server und konfigurieren Sie ihn entsprechend. Erstellen Sie eine VM in VMware vSphere. Weisen Sie der VM eine virtuelle vGPU zu, die auf der physischen Grafikkarte basiert. Dies ermöglicht der VM den Zugriff auf die vGPU-Ressourcen. Installieren Sie die entsprechenden Treiber für die vGPU in der VM. |

| Direct Passthrough (Direct Assignment) | Stellen Sie sicher, dass Ihre Hardware und VMware-Version die Direct-Passthrough-Funktion unterstützen. Dies erfordert in der Regel Intel VT-d- oder AMD-Vi-Technologie für die I/O-Virtualisierung. Konfigurieren Sie den VMware ESXi-Hypervisor entsprechend, um Direct Passthrough zu aktivieren. Weisen Sie der gewünschten VM die physische Grafikkarte direkt zu. Dadurch erhält die VM die volle Kontrolle über die Grafikkarte, und sie wird nicht mit anderen VMs geteilt. Installieren Sie die entsprechenden Treiber für die Grafikkarte innerhalb der VM. |

| GPU-Passthrough | Stellen Sie sicher, dass Ihre Hardware und VMware-Version die GPU-Passthrough-Funktion unterstützen. Dies erfordert in der Regel Intel VT-d- oder AMD-Vi-Technologie für die I/O-Virtualisierung. Konfigurieren Sie den VMware ESXi-Hypervisor entsprechend, um GPU-Passthrough zu aktivieren. Weisen Sie der gewünschten VM die Grafikkarte(n) direkt zu. Installieren Sie die entsprechenden Treiber für die Grafikkarte(n) innerhalb des Gastbetriebssystems. |

Kubernetes

vSphere Tanzu ist eine Abstraktion um Kubernetes in vSphere zu integrieren. vSphere Pods (CRX, Container Runtime for ESXi) sind optimierte VMs mit NUMA Kompatiblität. Der Linux Kernel und die Container engine (Kubernetes) sind Teil des CRX (der ESX Distribution). Kein BIOS, USB, PCI Check oder so, der Kernel bootet in Millisekunden. Die so orchestrierten Container sollen 30 mal schneller als in gewöhnlichen Linux VMs und 8mal schneller als auf bare metal Kubernetes starten. Siehe Kubernetes for the vSphere Admin. Als Netzwerk-API nutzt die Distribution Calico, nicht Flannel. Die MTU (maximal transmission unit) in Netzwerk-Frames soll in ESXi (vNIC) aber auch auf Switch-Level ausschlaggebend sein. Stichwort Jumbo-Frames in L2 Switching und L3 Routing.

Container Images werden in einer eigenen ESX Hardware-Registry (Harbor) abgelegt. Diese kann im vSphere Client administriert werden.

In vSphere nennt man „Persistent volume claims“ für Container „first class disks“. Diese sind im vSphere Datastore aufgelistet.

Features

- Flash Read Cache → Zuweisung von SSDs als Cache zu VMs VMWare Docs.

- Storage I/O control → erlaubt die Begrenzung von input/output Operationen pro Sekunde für jede VM VMWare Docs.

- Network I/O control → erlaubt die Begrenzung von Netzwerk input/output Operationen pro Sekunde für jede VM VMWare Docs.

- vSphere Replication → Replikation von VMs von einem in ein anderes Datacenter auf per VM Basis.

- vSphere DRS → um ESXi Hosts in Ressourcencluster zu gruppieren. https://www.windowspro.de/thomas-drilling/vsphere-drs-funktionsweise-automatisierungsmodi, https://www.vmware.com/at/products/vsphere/drs-dpm.html

- Raw device mapping → Option in VMware-Server, einen Datenspeicher an eine virtuelle Maschine anzubinden

Dateisystem

Das VMWare-eigene Dateisystem heisst VMFS - die aktuelle Version ist VMFS5, es gibt auch VMFS3 (veraltet). Es wurde entwickelt, um Festplatten-Images virtueller Maschinen, einschließlich Snapshots, zu speichern. Mehrere Server können dasselbe Dateisystem gleichzeitig lesen/schreiben, während einzelne Dateien der virtuellen Maschine gesperrt sind. VMFS-Volumes können „dynamisch wachsen“ (zerstörungsfrei in der Größe vergrößert werden), indem mehrere VMFS-Volumes zusammengeführt werden.

Networking

Man spricht von

- Underlaying

- Overlaying

Network. Underlaying ist das physikalische, Overlaying das darauf aufgebaute, virtualisierte Netzwerk. Siehe hier.

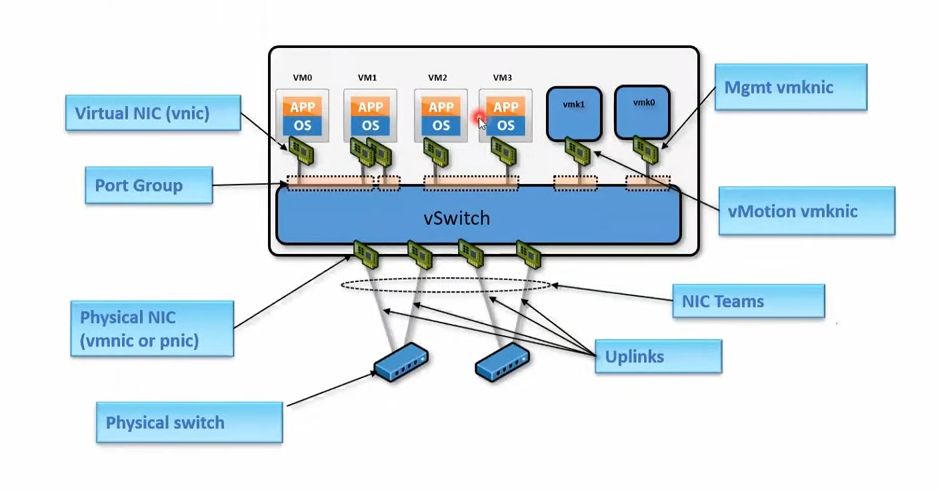

Ein „distributed virtual switch“ wird auf Clusterebene erstellt und steht mehreren ESX-Hosts zur Verfügung. Ein normaler „virtual switch“ steht nur dem ESX-Host zur Verfügung auf dem er angelegt wurde. Übersicht über die Unterschiede

- vSS - vSphere standard switch

- vDS - vSphere distributed switch Verteilte virtuelle Switche

NICs werden verschieden bezeichnet.

- vnic (Virtual nic)

- vmknic (VM kernel nic - management)

- vmnic oder pnic (physische ESX nic)

Netzwerkrichtlinien werden mittels Port-Groups umgesetzt.

Virtual network adapters

- vNIC - VMs interface

Physical Network Adapter

- pNIC - Kommunikation mit Einheiten ausserhalb des ESX Host

Virtual Switch

Layer 2 im OSI Modell. Werden auf Host-Level erstellt. Sind mit physikalischen Adaptern (pNIC) verbunden. Virtualisieren Port-Groups und VLANs. Auch NIC-Teaming kann angewendet werden.

- Transferiert Pakete zwischen vnic, vmknic und pnic.

Port Groups

- Port Groups mit gleichen Eigenschaften. Werden zum Erstellen von Netzwerkrichtlinien (was mit was kommunizieren darf) benutzt.

Uplinks

- Verbindungen von pNICs zu physikalischen Switches

Nic Teaming

- Eine Gruppe von pnic die mit dem selben physikalischen Netzwerk verbunden sind. Siehe NIC Teaming

Network Traffic Types

Im Data Center Bereich ist oft von Nord-Süd bzw. Ost-West Traffic die Rede. Ost-West Traffic bezieht sich dabei auf den Traffic innerhalb des privaten Netzwerk während Nord-Süd Traffic den Verkehr aus und in die Public Cloud beschreibt.

Virtual machine traffic

- Von und zu VMs

- voneinander isoliert

vMotion Traffic

- Wenn eine VM von einem ESX Host zu einem anderen verschoben wird

- Muss dedicated und isoliert sein

Management traffic

Beim Installieren wird einem ESX Host eine IP Adresse zugewiesen (vmknic), diese ist dann im Management-Netz.

- sollte vom VM traffic isoliert sein

- beinhaltet „Heart Beats“ wenn vSphere HA (high availability) aktiviert ist

Storage traffic

FT Traffic

Fault Tolerence ist eine Technik zum Schutz der VM-Workload, um eine Betriebszeit von 100 % bereitzustellen und erfordert, dass der VMware-Cluster HA-fähig (high availability) ist. FT ist eine Pro-VM-Konfiguration.

Jede VM hat ihre eigene unabhängige Speicher- und Arbeitsspeicherzuweisung. Es müssen jedoch einige Metadaten auf einem freigegebenen Datenträger gespeichert werden, um den primären Datenträger zu identifizieren und ein Failover auf den sekundären durchzuführen, falls der primäre ausfällt.

Die typischen Vorgänge in der primären VM, wie z. B. eine einfache Berechnung – A + B = Ergebnis C , C wird an den lokalen Speicherort im Speicher der primären VM geschrieben. Das Ergebnis C wird auch über das Netzwerk an die sekundäre VM gesendet, um es in ihren Speicher zu schreiben. Dieser Prozess wird als Fast-Checkpointing bezeichnet. Er umfasst die Übertragung von Änderungen des Speicherstatus, des Festplattenstatus und des Einstellungsstatus zwischen primären und sekundären VMs. Es gibt einen VMkernal-Port, der dafür bestimmt ist, diesen Datenverkehr auf jedem Knoten zu übertragen.

Dieser Datenverkehr wird als FT-Protokollierungsdatenverkehr bezeichnet.

Falls der primäre Knoten/die VM aus irgendeinem Grund ausfällt. Die sekundäre VM übernimmt die Rolle der primären, indem sie die Metadaten auf der gemeinsam genutzten Festplatte aktualisiert und eine neue sekundäre erstellt wird. Der FT-Protokollierungsdatenverkehr wird zwischen der neuen primären und der neuen sekundären wieder aufgenommen. Der Betrieb auf Primary wird aufgrund des schnellen Checkpoints ununterbrochen fortgesetzt, es gibt nahezu keinen Datenverlust und keine Ausfallzeiten.

- Should be isolated completely

- Heavy I/O, Low latency

vSAN traffic

- Generiert bei R/W Operationen über vSAN Nodes hinweg

VXLAN traffic

- Generiert während VTEP to VTEP (virtual tunnel end point) traffic in VMWare NSX (VMWare Netzwerkmanagement tool)

Provisioning traffic

- VM Cloning operationen (vMotion?)

Powershell

Connecting to vSphere or ESXi

Connect-VIServer -Server "vcenter_or_host_name" -User "username" -Password "password"

Get all VMs:

Get-VM

Get VM details:

Get-VM -Name "VM_Name"

Get VM guest OS details:

Get-VMGuest -VM "VM_Name"

Get VM’s resource allocation (CPU, Memory, etc.):

Get-VM -Name "VM_Name" | Select-Object Name, NumCPU, MemoryMB

Managing VMs

Start a VM:

Start-VM -VM "VM_Name"

Stop a VM (gracefully):

Stop-VM -VM "VM_Name" -Confirm:$false

Force stop a VM:

Stop-VM -VM "VM_Name" -Kill:$true -Confirm:$false

Restart a VM:

Restart-VM -VM "VM_Name" -Confirm:$false

Cloning a VM

Clone a virtual machine to create a new one:

New-VM -Name "New_VM_Name" -VM "Source_VM_Name" -Datastore "Datastore_Name" -VMHost "VMHost_Name"

Snapshot Management

Create a snapshot:

New-Snapshot -VM "VM_Name" -Name "Snapshot_Name" -Description "Snapshot description"

Get VM snapshots:

Get-Snapshot -VM "VM_Name"

Revert to a snapshot:

Set-VM -VM "VM_Name" -Snapshot "Snapshot_Name"

Remove a snapshot:

Remove-Snapshot -Snapshot "Snapshot_Name" -Confirm:$false

Managing ESXi Hosts

Get ESXi host information:

Get-VMHost

Check the version of ESXi:

Get-VMHost | Select-Object Name, Version, Build

Put ESXi host into maintenance mode:

Set-VMHost -VMHost "esxi_host_name" -State Maintenance

Exit maintenance mode:

Set-VMHost -VMHost "esxi_host_name" -State Connected

Managing Datastores

Get all datastores:

Get-Datastore

Get datastore details:

Get-Datastore -Name "Datastore_Name"

Rescan datastores on ESXi:

Get-VMHost | Get-VMHostStorage -RescanAllHba

Network Management

Get all network adapters (NICs):

Get-VMHostNetworkAdapter -VMHost <vm-name>

Get all vSwitches:

Get-VirtualSwitch

Create a new vSwitch:

New-VirtualSwitch -VMHost "esxi_host_name" -Name "vSwitch_Name" -NumPorts 128

Create a port group:

New-VirtualPortGroup -VirtualSwitch "vSwitch_Name" -Name "PortGroup_Name"

Managing vCenter Clusters

Get all clusters:

Get-Cluster

Get information about a specific cluster:

Get-Cluster -Name "Cluster_Name"

VM Affinity Rules

Create and manage affinity or anti-affinity rules to control how VMs are placed in the cluster.

Create VM-Host affinity rule:

New-DrsVMHostRule -Cluster "Cluster_Name" -VM "VM_Name" -VMHost "Host_Name" -Enabled $true

Logging Out from vSphere or ESXi

After your automation tasks are done, you can disconnect from the server:

Disconnect-VIServer -Server "vcenter_or_host_name" -Confirm:$false